0. 提問、互動到協作的新範式

許多人與大型語言模型(LLM)的初次接觸,始於在 ChatGPT 的文字框中輸入一個問題,然後驚訝於它能以流暢、擬人的方式給出答案。這種體驗雖然神奇,卻也容易讓人產生誤解,將其視為一個無所不知的「魔法黑盒子」。然而,這種看法僅僅觸及了表面。要真正駕馭這些強大的工具,我們必須超越單純的「對話」,深入理解其運作的核心機制——從它的訊息壓縮本質,到我們與它之間互動所共同建構的上下文窗口(Context Window)。

透過系統性地拆解當代LLM的實用框架,我們就能從一個基礎使用者,蛻變為能夠充分利用其思考、工具整合、多模態互動與個人化定製能力的專家,也就是將其從一個偶爾使用的工具,轉變為深度整合於個人生活與專業工作流程中,不可或缺的認知夥伴。

1. 「一個會說話的 1TB 壓縮檔」

在我們開始探索之前,必須先建立一個正確的模型觀念。當你與 ChatGPT 或任何類似的模型互動時,你究竟在與什麼對話?

答案並非一個全知的意識,而更像是一個巨大的、經過特殊處理的「有損壓縮檔」。這個壓縮檔的原始資料,來自整個公開網際網路的浩瀚文本、圖片以及影音資料。

1.1 知識的來源:預訓練(Pre-training)

LLM 的核心知識,來自於一個稱為「預訓練」的階段。想像一下,一個超級電腦花費數月時間,耗資數千萬美元,閱讀了幾乎所有能找到的網路文章、書籍、論文和程式碼。它的任務極其單純:在給定一段文本後,預測下一個最可能出現的詞元(token)。

為了完成這個任務,神經網路被迫學習語言的文法、句式、事實、邏輯、因果關係,甚至是不同文化背景下的語氣和風格。所有這些學習成果,都被壓縮並儲存在神經網路的數萬億個「參數」(parameters)中。這個過程就像製作一個ZIP壓縮檔,但這絕非無損壓縮。由於不可能完美記住所有資訊,模型只能捕捉到網際網路的「重點」或「感覺」。

這也因此帶來了一個重要的特性:知識截斷點(Knowledge Cutoff)。例如,GPT-4o 的預訓練可能是在幾個月甚至一年前完成的。因此,它對於近期發生的事件一無所知,因為這些資訊並未包含在它的「壓縮檔」裡。要讓模型處理最新資訊,就需要後續將提到的「工具使用」。

1.2 人格的由來:後訓練(Post-training)

一個只會生成網際網路文檔的模型,對普通用戶來說並不實用。我們需要的是一個能聽懂指令、回答問題的「助理」。這就是「後訓練」階段的作用,它相當於為這個巨大的壓縮檔安上一個「可靠的人格」。

在這個階段,開發人員會用一個全新的資料集——由人類標註員精心製作的「對話」資料集——來微調模型。這個資料集包含了大量的提問與理想的回答範例。透過學習這些範例,模型學會了扮演一個樂於助人、遵循指令、安全無害的AI助理角色。

所以,我們可以想像LLM會這樣自我介紹:

你好,我是一個大型語言模型。你可以把我看作一個大約1TB的壓縮檔。我的知識來自於約半年前我完整閱讀過的網際網路,但我只記得大概。我討人喜歡的個性,則是由人類標註員透過範例教給我的。

1.3 「協作書寫一個不斷延長的 Token 序列」

當我們在聊天視窗中看到一來一回的對話氣泡時,其底層發生的事情更為精確。我們的每一次輸入和模型的每一次回應,都會被切分成稱為「詞元」(Tokens)的最小語意單元。一個Token可以是一個詞、半個詞或一個標點符號。

例如,「寫一首關於大型語言模型的俳句」這個提示在底層會被轉換為一個由x個Token組成的一維序列。模型的回答「字句如川流,無盡回響意念空,幽思未曾見」則是另一個y個Token的序列。

這其實不是兩段獨立的文本,而是一個連續的「Token序列」(Token Stream)。當我們輸入問題並按下發送時,我們是在開頭寫入了我們的Token序列;接著,我們將控制權交給模型,模型則繼續在這個序列的後面追加它的Token序列,直到它生成一個表示「我說完了」的特殊Token,再將控制權交還給我們。

我們其實與模型正在共同協作,擴展一個單一的、一維的Token序列。這個序列所在的空間,被稱為「上下文視窗」(Context Window),它就像這次對話的「工作記憶」。所有在這個視窗內的資訊,模型都可以直接取用。

理解了這個「壓縮檔」和「Token序列」的核心概念後,我們就能更深刻地理解LLM的行為、優勢與局限,並學會如何更有效地與之互動。

2. 如何與模糊的內在知識溝通

既然我們知道LLM是一個基於其「記憶」進行機率性回應的實體,我們就應該調整與之互動的策略。

2.1 選擇合適的問題

什麼樣的問題適合直接詢問LLM的「內在知識」?答案是那些普遍、常見且非時效性的資訊。

例如,我可以詢問:「富良野薰衣草大約什麼時候會滿開?」這是一個很好的問題。原因有二:第一,這類花季資訊每年都會被大量記錄與報導,因此模型在預訓練階段會反覆接觸,記憶深刻。第二,花季的時間雖可能受氣候影響略有差異,但年年相近,屬於「低變動、高可預測性」的知識。模型可能會回答「7月中旬是盛開高峰」,雖不保證精確對應當年天氣,但整體可信度極高,且能快速與觀光局網站或花況直播做交叉驗證。

另一個例子是我詢問:「30歲男性的建議睡眠時間大約是多少?」模型可以根據大量醫學文獻與健康建議,回應「一般建議為 7 至 9 小時」。這類回應屬於以統計平均為基礎的健康建議,在大多數人身上都有參考價值。然而,這仍然需要我根據自己的生活型態、作息品質與精神狀況來做調整與驗證。畢竟模型給出的只是「一般建議區間」,並非針對個人的精密診斷。即使如此,這樣的互動方式,在日常健康管理中非常實用。

2.2 認知資源─上下文視窗

隨著對話的進行,上下文視窗中的Token會越來越多。這裡有一個重要的使用方式:當切換主題時,務必點擊「開啟新對話」(New Chat)。

這麼做有兩個好處:

- 提升準確性:

上下文視窗是模型的工作記憶。如果裡面堆滿了與當前問題無關的舊資訊,模型在生成新答案時可能會「分心」,導致回答品質下降。 - 提升效率:

上下文視窗越長,模型計算下一個Token所需的時間和計算資源就越多。清空視窗能讓模型反應更快。

將上下文視窗視為一種寶貴資源。保持其簡潔、相關,能讓你的LLM夥伴表現得更聰明、更敏捷。

2.3 認識你的模型

LLM並非生而平等。在ChatGPT的介面左上角,你可以選擇不同的模型,例如o3、o4-mini-high、o4-mini、GPT-4o或其更小、更快的版本。在其他平台,如Claude、Gemini、Grok等,也存在類似的模型層級。

通常,這些公司會將其最大、能力最強的模型作為付費方案的核心。例如,免費版的ChatGPT可能主要使用GPT-4o mini,它在寫作創意、知識深度和邏輯推理上都不及付費版用戶能使用的旗艦模型GPT-o3。

這就引出了一個「LLM顧問團」(LLM Council)的概念。在處理重要或複雜的問題時,一個有效的策略是將同一個問題拋給多個不同的頂級模型(如ChatGPT的GPT-o3、Anthropic的Claude 4 Sonnet、Google的Gemini 2.5 Pro、xAI的Grok 4),然後綜合比較它們的回答。每個模型都有其獨特的「個性」和微小的能力差異。在做旅行規劃時,我就會詢問所有模型推薦的目的地,並從中汲取靈感。

你需要根據自己的使用場景和預算(我個人只訂閱ChatGPT Plus以及Gemini Pro),做出明智的權衡。對於專業工作,特別是涉及程式設計或複雜分析的任務,投資於頂級模型的費用往往物超所值。

3. 能力的躍遷——從「回答」到「思考」

近期來,LLM領域最大的突破之一,是「思考模型」(Thinking Models)的出現。這些模型在傳統的三階段訓練(預訓練、監督式微調)之後,增加了一個基於強化學習(Reinforcement Learning)的階段。

在這個階段,模型會被給予大量複雜的數學、程式設計和邏輯推理問題,並被鼓勵去「練習」解決它們。模型可以自由探索不同的解題路徑,嘗試、犯錯、回溯、修正假設。那些最終能導向正確答案的「思維鏈」(Chain of Thought)會得到獎勵。

這個過程,讓模型內化了一種類似人類的「獨白思考」(Inner Monologue)。當你向一個思考模型提問時,它不再是直接給出答案,而是會先在內部生成大量的思考步驟,這個過程可能需要幾十秒甚至幾分鐘。

3.1 思考模型的應用場景

思考模型的威力在於處理高難度、需要多步推理的任務。

一個典型的例子是除錯程式碼。我最近使用Gemini 2.5 Pro寫了一段Tampermonkey 抽取網頁資料的腳本,也試圖在網頁上注入一個按鈕來執行。很奇妙的是,看起來正確的代碼卻無法成功注入按鈕,擷取資料也有闕漏。為了節省上下文,我先問了ChatGPT-4o,尋求解答,但它只給出了一些常規的建議,未觸及問題核心。

接著,我切換到OpenAI的思考模型(目前以o系列命名,如o3),並給了它完全相同的提示。模型花了將近一分鐘的時間進行「思考」(介面上會顯示思考過程的摘要),然後精準地指出了問題所在:注入位置的選擇。這個答案直接解決了我的問題。

有趣的是,我也將這個問題給了Gemini 2.5 Pro,雖然普遍而言Gemini 2.5 Pro在Chatbot Arena能力排名第一,但它似乎很難解決自己生成的程式碼bug。這再次印證了「LLM顧問團」策略的有效性。

由於部分公司對思考模型有使用限制,因此使用原則是: 對於簡單問答(如旅行建議),使用標準模型以獲得快速回應。當你遇到複雜難題,或者對標準模型的回答不滿意時,再切換到思考模型,給予它充分的時間去「深思熟慮」。

4. 打破壁壘——透過「工具」連接真實世界

到目前為止,我們討論的LLM本質上仍是一個封閉、有損的「壓縮檔」。為了讓它能夠與現實世界互動,部分LLM已經有了使用工具(Tools)的能力。

4.1 工具:網際網路搜尋

這是最基本也最重要的工具,它解決了LLM的「知識截斷」問題。

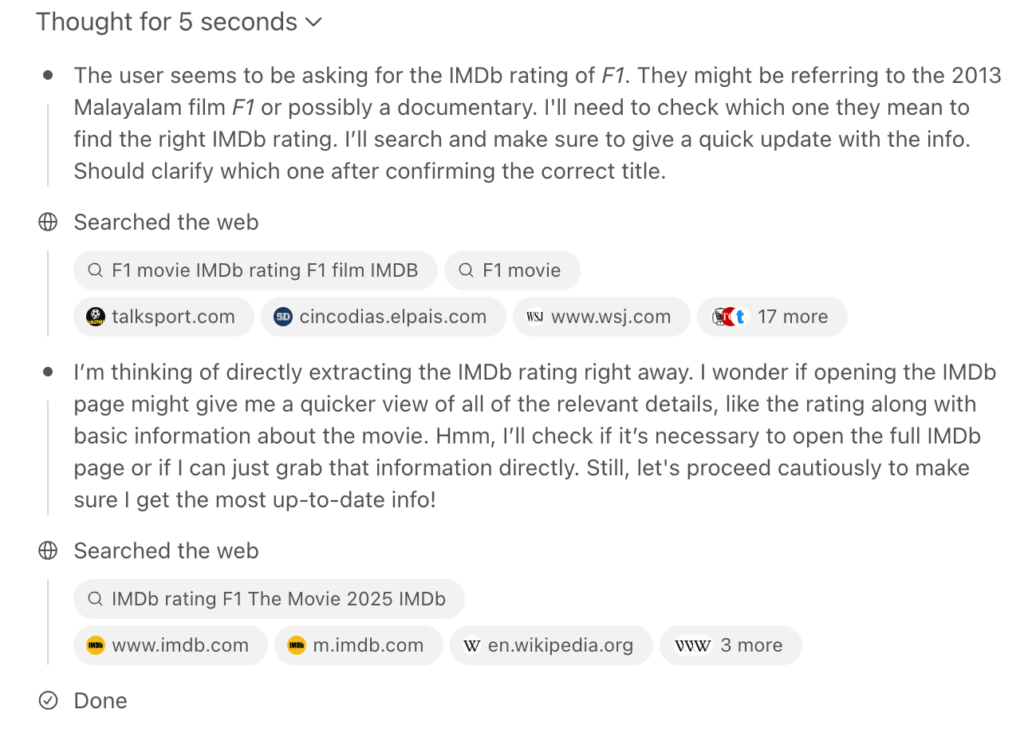

假設我想知道院線電影F1 IMDb的評分時,這是一個非常新的資訊,模型的內在知識庫裡肯定沒有。在過去,我需要自己去Google搜尋,然後該網頁中搜尋F1尋找答案。

現在,我可以將這個問題交給具備搜尋能力的ChatGPT-4o,其工作流程如下:

1. 模型自動識別出這個問題需要即時資訊。

2. 模型生成一個或多個搜尋查詢。

3. 應用程式接收到這個指令,執行搜尋,並抓取排名靠前的幾個網頁的全部文本。

4. 這些網頁文本被「塞進」當前對話的上下文視窗中。

5. 模型閱讀這些網頁內容,並從中總結出準確的答案附上資料來源。

這個功能極大地擴展了LLM的實用性。當你需要最新資訊、會隨時間變化的資訊(如公司財報、產品價格)或非常小眾的資訊時,甚至需要進行事實查核時,都應該優先使用搜尋工具。

4.2 工具:深度研究(Deep Research)

如果說單次搜尋是讓LLM看幾篇新聞,那麼「深度研究」就是讓它為你寫一篇研究報告。這是一個結合了大規模網際網路搜尋和思考模型能力的進階功能。

前陣子我朋友說股市恐慌是財富重分配的機會。當時我確實沒有一個完整的策略,可以執行;但之後我啟用了深度研究功能的ChatGPT提出了詳細問題,涵蓋了研究歷史震盪數據、標的選擇及投入原則等。

模型花了將近8分鐘時間,它自主地進行了數十次搜尋,閱讀了包括歷史資料、標的(個股、2x ETF和健期權)在內的38個來源,最終生成了一份結構清晰、引用詳實的綜合報告。

雖然這份報告同樣需要批判性地看待,並親自查證關鍵引文,但它在幾分鐘內為我完成的資訊收集和整理工作,可能需要我自己花上數小時。對於需要快速了解一個陌生領域的場景,例如商品比較、技術調研,深度研究功能非常好用。

4.3 工具:程式碼執行

LLM在數學運算上其實非常糟糕,因為它的本質是語言預測,而非精確計算。一個複雜的乘法 12345 * 67890,很多模型會直接「在腦中」計算並給出一個看似合理但錯誤的答案。

具備程式碼執行工具的LLM則會「意識到」自己的短處。它不會嘗試心算,而是會:

1. 寫下一行Python程式碼:`print(12345 * 67890)`。

2. 將這行程式碼交給一個安全的、沙箱環境中的Python直譯器執行。

3. 獲取直譯器的輸出結果。

4. 將這個精確的結果呈現給你。

這個能力的延伸極其強大。你可以上傳一個Excel表格,然後用自然語言指揮它進行資料清洗、分析、視覺化繪圖,甚至是建立預測模型;當然,你也可以要求將完整的程式碼返回,之後在本機執行。

我分析公司業績增長趨勢的例子中,我僅用幾句話就讓它繪製了帶有對數座標和趨勢線的圖表。然而,使用這類工具時,審查它生成的程式碼是必要的。它是一個強大的助手,但你仍需是那個負責監督和驗證的專家。

4.4 工具:程式設計IDE整合與UI生成

對於專業開發者而言,在網頁上複製貼上程式碼片段的效率太低。真正的革命發生在將LLM直接整合進整合式開發環境(IDE)中。像Cursor這樣的工具,它本身就是一個IDE,但內建了強大的LLM。

開發者不再需要逐行編寫程式碼,而是進入一種被稱為Vibe Coding的模式。你可以用高層次的指令描述你的需求,例如:「建立一個井字棋遊戲」、「當有玩家獲勝時,加入五彩紙屑慶祝效果和勝利音效」。LLM代理會自動理解需求,安裝必要的函式庫,並在多個檔案之間修改程式碼來實現功能。幾分鐘內就透過這種方式完成了一個功能完整的井字棋應用。

而Claude的Artifacts功能則是在另一個方向上的探索。它可以根據你的需求,即時生成一個可以在瀏覽器中直接互動的預覽。例如,你可以讓它把一段文字轉化為一個抽認卡(Flashcard)練習應用,或者將一個複雜章節的內容,生成一個Mermaid.js概念關係圖,這對於視覺化思考者來說極其有用。

ChatGPT及Gemini也有Canvas功能,也有一定程度執行代碼或者生成UI的預覽功能。

5. 語音、圖像與影像的多模態革命

LLM正在迅速超越文字的束縛。其底層的Transformer架構是模態無關的,只要能將圖像、語音或影像「Tokenized」,模型就能以同樣的方式學習和生成它們。

5.1 語音互動

語音互動有兩種層次:

- 「偽」語音互動:

這是將「語音轉文字」(STT)和「文字轉語音」(TTS)兩個獨立功能串接起來。你在手機上按住麥克風說話,手機將其轉為文字發送給LLM;LLM返回文字後,手機再將其朗讀出來。這很方便,但模型本身仍在處理文字。 - 「真」語音互動:

這是指模型能夠直接處理和生成語音Token。ChatGPT的「語音模式」就是代表,不過現在幾乎大型的公司都已經有相關功能。在這種模式下,對話是端到端的語音流,不涉及中間的文字轉換。這使得互動極其流暢、低延遲,並能捕捉到語氣、情感等非語言資訊。不同的語音模式甚至提供了「浪漫」、「陰謀論」等多種「人格」,滿足各種需求。

此外,Google的NotebookLM開創了另一種有趣的語音互動:生成Podcast。你可以上傳任何文件(如一篇學術論文),它就能為你生成一段數十分鐘、由兩位AI主播對談的深度解析Podcast。這對於在通勤或散步時被動學習新知識非常有用。

5.2 圖像與影像互動

圖像輸入:你可以上傳任何圖像並向LLM提問。這在現實生活中有著廣泛的應用:

- 拍下食品營養標示,詢問各種成分的作用和潛在風險。

- 上傳體檢報告,讓它幫你解讀各項指標的意義(注意:僅供參考,不能替代醫囑)。

- 截圖看不懂的數學公式或迷因(meme),讓它為你解釋。

- 拍下牙膏成分表,讓它分析哪些是核心功能成分,哪些是可能無益的添加劑。

圖像生成:以OpenAI的和Midjourney為代表,你可以用文字描述生成任何風格的高品質圖像,常用於製作簡報插圖、部落格封面或社交媒體素材。

影像互動:最新的進展是讓LLM能夠即時「看見」。在ChatGPT的行動應用中,你可以開啟相機,將鏡頭對準房間裡的任何物體,並與模型進行實時對話。你可以問它「這本書是什麼?」、「我桌上的這個二氧化碳監測儀讀數正常嗎?」、「這幅地圖是哪裡的?」。它就像一個永遠在你身邊的、博學的朋友。

6. 量身訂製——打造你的個人化AI

6.1 記憶(Memory)

預設情況下,每一次新對話都是一次「失憶」的開始。ChatGPT的「記憶」功能打破了這一點。當你在對話中透露了個人偏好或重要資訊時(例如,你告訴它你認為「90年代是好萊塢的黃金時代」),它可以將這個資訊點儲存到一個關於你的專屬資料庫中。

在之後的每一次對話開始前,這些「記憶」會被自動載入到上下文視窗的頂部。久而久之,模型會越來越了解你,給出的建議(如電影推薦)也會更加個人化。你可以隨時管理、編輯或刪除這些記憶。

此外,ChatGPT也有Chat History Reference(歷史對話參考)的功能;模型會自動從過往聊天內容抽取相關資訊並加以應用,尤其是常提及或反覆出現的細節,是非常好用的功能。

6.2 客製化指令(Custom Instructions)

這是一個全域設定,可以讓你預先定義模型的行為準則和你的個人背景。

例如,你可以這樣告訴它來跟看護互動:

你是一台翻譯機器,將所有的中文輸入翻譯成英文以及印尼文。格式如下

英文:

印尼文:

這省去了在每次對話中重複說明的麻煩,讓模型從一開始就以你喜歡的方式與你互動。

6.3 客製化專案

如果你發現自己經常重複使用某個複雜的提示(Prompt),那麼客製化專案(ChatGPT稱為Project、Gemini稱為Gem)就是為你準備的。它允許你將一個詳細的、包含背景、指令和範例的提示,打包成一個獨立的、可重複使用的「應用」。

我在閱讀大量金融資訊時就創建專案來幫我進行所有摘要、提煉洞見,最後產生行動建議。

設計提示背後的一些關鍵,就是提供「少樣本提示」(Few-shot Prompting)。在指令中,我不僅描述了任務,還提供了幾個完整的「輸入-輸出」範例。這極大地提升了模型理解任務的準確性,使其表現穩定而出色。但隨著模型越來越進步,有時候只要將需求簡要說明就可以了。

7. 從工具到夥伴的思維轉變

我們從一個簡單的問題開始:如何使用大型語言模型?現在,我們看到了一幅遠比「聊天」宏大得多的圖景。

一個真正的大型語言模型生態系,是一個以「壓縮的網際網路」為知識核心,以「Token」為媒介,並透過「思考能力」和「工具使用」不斷擴展其邊界,最終透過「多模態」和「個人化」深度融入我們感知和工作流程的複雜系統。

從標準的問答,到啟用思考模式解決難題;從利用網路搜尋獲取新知,到指揮進階資料分析工具繪製圖表;從上傳圖片辨識萬物,到開啟即時影像進行實景對話;從使用他人創建的通用模型,到打造專屬於你的客製化專案。這些進展,無疑也為工作及學習帶來了新的範式。

當我們不再將LLM視為一個等待提問的被動工具,而是將其看作一個可以被引導、被賦能、被訓練的認知夥伴時,我們才算真正釋放了它的潛力。

只是當我們的數位協作者不僅能言善道,更能思考、研究、計算、編碼和創造時:

在下一個十年,什麼才是我們不可替代的核心價值?

這或許是我們今天就應該開始思考的問題。

8. Appendix 知識地圖

A New Paradigm

提問、互動到協作

駕馭大型語言模型 (LLM),將其從神奇的魔法黑盒,轉變為深度整合於個人與專業工作流程的認知夥伴 (Cognitive Partner)。

Conceptual Model

會說話的壓縮檔

與其將LLM視為全知的意識,不如理解為一個巨大的有損壓縮檔。其知識源自預訓練階段對整個網際網路的學習,並被壓縮存儲於數萬億個參數中,這也導致了其知識存在截斷點。

人格的由來

透過後訓練階段 (RLHF),模型學習人類標註的對話範例,學會扮演一個樂於助人、安全無害的AI助理角色。

協作的本質

我們與模型的互動,是在一個稱為「上下文視窗」的工作記憶中,共同協作書寫一個不斷延長的 Token 序列。

Advanced Capability

思考

「思考模型」在給出答案前,會先在內部生成大量的思考步驟 (Chain of Thought),類似人類的「內心獨白」。這使其在處理需要多步推理的複雜任務 (如程式除錯) 時表現卓越。

// 案例:解決程式碼注入 Bug

User: “我的 Tampermonkey 腳本無法成功注入按鈕…”

Thinking Model: (思考近一分鐘後) “問題在於注入時機與DOM選擇器的精準度,應改為…”

有效溝通

-

選擇合適問題:

優先詢問普遍、常見、非時效性的內在知識。 -

管理上下文視窗:

切換主題時開啟新對話,保持工作記憶的簡潔與相關性。

Real-world Connection

工具

透過使用工具,LLM打破了自身知識庫的壁壘,連接到真實世界。

搜尋與執行

基本搜尋解決了「知識截斷」問題;程式碼執行則彌補了模型在精確計算上的短處,兩者都是連接現實數據的關鍵橋樑。

838102050

開發者整合

透過IDE整合 (如Cursor) 或UI生成 (如v0),開發者可以高層次指令快速建構應用,實現從需求到功能的無縫轉換。

Model Selection

LLM 顧問團

面對重要問題時,可將同一提示拋給多個頂級模型,綜合比較其回答以獲得更全面的視角與更可靠的答案。

Beyond Text

多模態革命

LLM正在超越文字,能夠直接處理和生成語音、圖像、影像的Token。這使得互動更加自然、直觀,並開啟了全新的應用場景。

語音互動

從「語音轉文字」到端到端的「真」語音互動,實現低延遲對話。

圖像與影像

上傳圖片即可分析,或開啟相機進行即時場景對話。

Tailored For You

量身訂製

- 記憶 (Memory): 自動儲存對話中的個人偏好與情境,讓模型越用越懂你。

- 客製化應用 (GPTs): 將複雜提示、知識與工具打包成可重複使用的獨立應用。

From Tool to Partner

思維轉變

當我們將LLM視為可引導、賦能、訓練的認知夥伴 (Cognitive Partner) 時,才算真正釋放了它的潛力。

在下一個十年,什麼才是我們不可替代的核心價值?

The question we should start thinking about today.